Durchschummeln (c)

Bedroht KI die Universität in der Existenz?

Das Ende der Hochschulbildung auszurufen, wäre verfrüht. Seit über tausend Jahren erweisen sich Universitäten als widerstandsfähig und anpassungsfähig. Schon in den 2010er-Jahren glaubten viele, die Massive Open Online Courses (MOOCs) würden das Präsenzstudium überflüssig machen.

Was wir aus der MOOC-Welle gelernt haben

Video-Vorlesungen, die Millionen von Studierenden kostenlos oder günstig erreichten, galten als revolutionär. Doch der Erfolg blieb begrenzt: Nur wenige schlossen die Kurse ab, legten Prüfungen ab oder erwarben einen akademischen Grad. Das Format zeigte Schwächen. Als Ergänzung geeignet, aber für eigenständiges, nachhaltiges Lernen fehlt der persönliche Austausch. Wer allein vor dem Bildschirm sitzt, verliert leicht die Motivation.

Bildung als Ware: Eine offene Flanke

Künstliche Intelligenz trifft die Hochschulen an einer Schwachstelle, die sich in den vergangenen 30 Jahren aufgebaut hatte: Bildung wird neoliberal zunehmend als Dienstleistung verstanden. Studierende werden als Kunden gesehen und nicht als zu bildende Staatsbürger, die anschließend die Gesellschaft bereichern.

In dieser Logik ist Bildung für Studenten eine Investition ins eigene ökonomische Fortkommen. Man liefert fertiggestellte Aufgaben ab und bekommt standardisierte Abschlüsse. Doch es gilt: Wenn KI auf Zuruf Inhalte liefert, ist der Verlust intellektueller Tiefe unvermeidbar.

Zwei Wege in die Zukunft: Verfall oder Erneuerung

KI könnte diese Entwicklung beschleunigen. Bereits kursieren „cheat sheets“ – Listen mächtiger KI-Prompts, die Aufgaben schnell zu lösen versprechen. Die Gefahr: Lernen verkommt zur hochstaplerischen Scheinleistung.

Doch es gibt auch die andere Möglichkeit: KI als Tutor und Sparringspartner. Systeme wie OneTutor (entwickelt an der TU München)1 erlauben individuelles Lernen. Chatbots decken Wissenslücken (das Know-that) auf und regen zur Vertiefung an. Richtig eingesetzt, können KI-gestützte Dialoge helfen, Inhalte wirklich zu verstehen.

Der Lernweg bleibt mühsam. Nur durch eigenes Ringen entsteht nachhaltiges Wissen. In dieser Logik unterstützt KI die Entwicklung von Medienkompetenz und Selbstorganisation (dem Know-how). Das wiederum ist am gegenwärtigen Arbeitsmarkt sehr gefragt. Auf diese Weise hätten die Universitäten einen Hebel in der Hand, ein Ort breiter intellektueller Entwicklung und geistiger Reifung zu bleiben. Die ist allerdings nur im Rahmen von strikten Regeln realistisch.

Was Hochschulen jetzt tun sollten

Der Schlüssel liegt in klaren Regeln, die auch exekutiert werden. Universitäten müssen den verantwortungsvollen Umgang mit den neuen Technologien lehren und selbst vorleben. Wer KI klug einbindet, kann die Qualität der Bildung steigern. Wer sich treiben lässt, riskiert Substanzverlust.

23. Juni 2025

1 Onetutor (23.06.2025). Study smarter with {1} One Tutor. https://onetutor.ai/

Durchschummeln (b)

Die Hochschulen reagieren – und scheitern

Halbherzig versuchen die Hochschulen, gegenzusteuern und lasten das Problem den Dozenten an. Einige Lehrende verbieten Chatroboter ganz, andere erlauben sie nur mit Quellenangabe. Manche setzen auf mündliche Prüfungen oder handschriftliche Klausuren. Doch all diese Maßnahmen stoßen rasch an organisatorische oder rechtliche Grenzen.

Die technischen Grenzen sind ohnehin evident: Selbst spezialisierte Erkennungsprogramme wie Turnitin oder ZeroGPT versagen. Sie produzieren Fehlalarme, diskriminieren Nicht-Muttersprachler oder lassen sich leicht austricksen. So sind bei Studierenden Umgehungspraktiken beliebt, wie mehrfaches Paraphrasieren durch unterschiedliche Tools.

Dozenten in der Krise

Lehrende fühlen sich zunehmend ohnmächtig und desillusioniert. Sie beurteilen in stundenlanger Arbeit Texte, die Chatbots in einer halben Minute ausgespuckt haben. Die akademische Integrität und Fairness wankt: Studenten, die ohne KI auskommen, sind im Nachteil gegenüber jenen Studenten, die nichts tun, außer die KI anzuwerfen. In digitalen und sozialen Medien finden sich zahlreiche Aussagen von Dozenten zur gegenwärtig unhaltbaren Situation.1

Die (westliche) akademische Kultur steht vor einem Wendepunkt – China setzt neue Maßstäbe

Lehrende sehen den eigentlichen Bildungsauftrag insgesamt – die Förderung kritischen Denkens, der Schreibfähigkeit und der intellektuellen Eigenständigkeit – gefährdet. Viele resignieren, sehnen die Pension herbei oder wollen sich aus der akademischen Lehre zurückziehen.2

Tertiäre Bildung ist angesichts dieses KI-Tsunamis neu zu denken. Statt eines „halb- oder vollautomatisierten“ Studiums wird ein Rückbesinnen auf das Lernen als aktiven Prozess notwendig werden: „We need to rethink higher ed [education], grading, the whole thing.“3

China ist uns um Riesenschritte voraus: Während der landesweiten Gaokao-Prüfungen (Uni-Aufnahmeprüfungen) in China vom 7. bis 10. Juni 2025 haben große chinesische KI-Anbieter ihre Dienste eingeschränkt. Insbesondere Funktionen wie Foto‑Erkennung oder Frage-Antwort-Funktionen waren vorübergehend deaktiviert. Das soll der Fairness bei Prüfungen dienen – und das tut es wohl!

11. Juni 2025

1 Koebler, J. (02.06.2025). Teachers are not ok. 404 Media. https://www.404media.co/teachers-are-not-ok-ai-chatgpt/

[404 Media ist ein unabhängiges, journalistisch geführtes Online-Medium, das sich auf investigative Berichterstattung über Technologie und digitale Kultur spezialisiert hat.]

2 Walsh, James (07.05.2025). Everyone ist Cheating Their Way Through College: ChatGPT has unraveled the entire academic project. The New York Magazine. https://nymag.com/intelligencer/article/openai-chatgpt-ai-cheating-education-college-students-school.html.

3 Koebler, J. (02.06.2025). Teachers are not ok. 404 Media. https://www.404media.co/teachers-are-not-ok-ai-chatgpt/

Durchschummeln (a)

Studenten schummeln sich ihren Weg durch die Hochschule

Mit einem provokanten Titel veröffentlicht das New York Magazine im Mai 2025 einen Essay1, der hohe Wellen schlägt. Die These: Künstliche Intelligenz hat den Hochschulbetrieb radikal verändert und bringt ihn zum Absturz.

Das Magazin, bekannt für seinen intellektuellen Stil und seine progressive Leserschaft2, liefert keine Satire, sondern eine beunruhigend ernst gemeinte Analyse. Der Artikel, 5.300 Wörter stark, erzählt von einer Praxis, die längst auch in europäischen Hörsälen Alltag ist: der massenhaften, stillschweigenden KI-Nutzung durch Studierende.

KI als Standard – nicht als Ausnahme

Der Artikel beginnt mit dem Erfahrungsbericht eines Columbia-Studenten. Ursprünglich abgelehnt, wurde er im zweiten Anlauf von dieser Ivy-League-Universität angenommen – dafür hatte er KI eingesetzt. Nun nutzt er ohne schlechtes Gewissen bei nahezu allen Studienleistungen generative KI. Essays, Notizen, Hausarbeiten, Programmieraufgaben: Alles wird mit ChatGPT & Co erledigt.

Damit steht er nicht allein. Der Artikel berichtet auf Basis von Studien und zahlreichen Interviews mit Studierenden und Dozenten: Die Mehrheit der Studenten verwendet KI regelmäßig. Das gilt quer durch alle Fachrichtungen und Hochschultypen, von Eliteschmieden bis Community Colleges.

„Das ist doch kein Betrug“ – das Selbstbild der Studierenden

Was sagt die akademische Jugend selbst dazu? Viele sehen den Einsatz von KI nicht als Mogelei, sondern als effiziente Alltagshilfe. Sie fühlen sich überfordert von Termindruck, digitalem Stress und den starren Prüfungsformaten. KI wird zur Krücke – oder zur Abkürzung. Dabei verschwimmt zunehmend die Grenze zwischen erlaubter Assistenz und unerlaubter Auslagerung.

Was auf dem Spiel steht: Kompetenz

Das eigentliche Problem liegt tiefer: Wenn Studierende ihre Aufgaben durch KI lösen lassen, verlieren sie die Chance, eigene Kompetenzen zu entwickeln. Kreativität, kritisches Denken, analytische Fähigkeiten. Alles, was ein Studium fördern soll, bleibt auf der Strecke. Das Resultat? Eine Generation von Absolvent:innen, die zwar Titel tragen, aber wenig Eigenleistung vorweisen können.

Vom Hochstapler zum Überflüssigen?

Die Ironie: Wer heute durch generative KI das Studium „effizient“ meistert, könnte morgen durch dieselbe Technik im Beruf ersetzt werden. Was einst Automatisierung und Industrieroboter dem Blue-Collar-Worker nahmen, nimmt nun die KI dem White Collar Worker, eventuell dem der sich bis hierher durchgeschummelt hatte. Die KI zerstört vor allem die erste Sprosse der Karriere-Stufenleiter, den Einstieg als unerfahrener Junior in das Berufsleben. Die generative KI hat diese erste Sprosse zerbrochen.

3. Juni 2025

1 Walsh, James (07 May, 2025). Everyone ist Cheating Their Way Through College: ChatGPT has unraveled the entire academic project. The New York Magazine. https://nymag.com/intelligencer/article/openai-chatgpt-ai-cheating-education-college-students-school.html.

2 Drei konsultierte Chatbots (ChatGPT, Gemini und DeepSeek) chrakterisieren das New York Magazine ähnlich: überdurchschnittlich gebildete und progressive Leser:innen, eine große digitale Reichweite; das Magazin genießt hohes Ansehen und ist daher einflussreich. Wikipedia vermerkt zahlreiche Medien-Preise, unter anderem zweimal den Pulitzer Prize for Criticism.

Wissenschaftstheorie 5: Die stoische Philosophie

Sei ein Stoiker – wie antike Philosophie im KI-Zeitalter hilft.

Was bei uns als „stoisch“ gilt – und warum das ein Missverständnis ist.

In Italien oder Frankreich bedeutet stoico/stoïque stark, souverän, charakterfest und mutig. Im romanischen Kulturraum wird dem Stoiker innere Reife und Würde zugeschrieben. Vor zweitausend Jahren zogen sowohl in Griechenland als auch im römischen Reich Sittenprediger durchs Land, die das stoische Gedankengut als vieldimensionale Lebenskunst propagierten.

Ganz anders im deutschen und englischen Sprachraum: Stoisch steht hier für leidensfähig, distanziert und teilnahmslos. Die britische stiff upper lip der oberen Schichten steht sinnbildlich für eine aufgesetzte Emotionslosigkeit. Stoisch zu sein, reduzierte sich auf ein marginalisiertes Buchwissen. Intellektuelle hatten im Spätmittelalter antike stoische Schriften einseitig übersetzt.

Die ursprüngliche stoische Philosophie, wie sie sich jetzt noch in der italienischen und französischen Alltagssprache widerspiegelt, war alles andere als kalt und gefühllos. Sie ist Lebenskunst, ein Weg zu Gelassenheit und Lebensfreude.

Lebenskunst aus Zeiten des Umbruchs – für Zeiten des Umbruchs.

Die Stoa entstand in Athen – nach dem Fall der attischen Demokratie und während der Umbrüche des hellenistischen Zeitalters. Die zentrale Einsicht wird bereits im ersten Satz eines antiken Handbuchs formuliert:

„Es gibt Dinge, die in unserer Macht stehen, und andere, die es nicht tun.“

(Epiktet, Enchiridion, Kap. 1)

Was sich nicht ändern lässt, sollte uns nicht aus der Fassung bringen. Energie wird dafür genutzt, was wir beeinflussen können. Das ist keine Flucht, sondern psychologisch kluge Selbststeuerung – gerade in schwierigen Zeiten. So wird man resilient und widerstandsfähig.

Stoiker im klassischen Sinn lehnen exzessive (!) Emotionen ab, jedoch nicht das Fühlen an sich. „Normale“ Gefühle sind erlaubt und oft hilfreich. Der Mensch soll nicht kalt, sondern klar, weltoffen und anpassungsfähig sein. Das hilft, in Harmonie mit der Natur, den Menschen und dem eigenen Körper zu leben.

Diese Haltung hat moderne Spuren hinterlassen, etwa in der Kognitiven Verhaltenstherapie (KVT), die gezielt mit Gedanken, Bewertungen und Gefühlen arbeitet. Auch in asiatischen philosophischen Systemen wie dem Konfuzianismus oder dem religionsphilosophischen Buddhismus finden sich vergleichbare Ideen.

Lachende Buddhas in einer Straßenwerkstätte in Myanmar, 2002

Was hat das mit KI zu tun? Sehr viel.

Wir leben 2025, in einer Zeit globaler Umbrüche, nicht nur politisch, sondern auch technologisch. Künstliche Intelligenz verändert unser Denken, Schreiben, Arbeiten und Kommunizieren. Stoische Prinzipien bieten einen Weg, mit dieser neuen Komplexität umzugehen:

- Gelassen bleiben, wenn dich Technik zu überfordern droht;

- den Fokus behalten, wenn dich Informationen überfluten;

- Lernfreude kultivieren, statt sich erschlagen zu fühlen und daher aufzugeben.

Seneca lobt die Lernbegierde. Er schreibt:

„Man darf weder beliebige Teile herausgreifen noch gierig das Ganze verschlingen wollen […] Die Last muss mit unseren Kräften in richtigem Verhältnis stehen.“

(Briefe an Lucilius, 108)

Übertragen auf KI heißt das: Wer Texte generieren lässt, sollte das Thema ansatzweise durchdrungen haben. Wer blind übernimmt, wird fremdbestimmt. Wer fragt, wer prüft, wer auswählt, der bleibt souverän.

Fazit: Sei ein Neo-Stoico!

Eine italienisch lebendige stoische Haltung im KI-Zeitalter heißt:

- Sich ein bisschen freuen, dass es die KI überhaupt gibt;

- wissen wollen, statt Infos bloß konsumieren;

- gelassen handeln, auch wenn die Technik überfordert;

- nicht alles glauben, was plausibel klingt

Statt die KI als "allwissenden Aristoteles" zu betrachten, sollten wir das Gespräch mit ihr führen wie ein neugieriger, aber kritischer Stoiker: offen, ruhig und bereit zur Prüfung.

22. Mai 2025

Quellen:

Epiktet, The Enchiridion, Kap. 1, Project Gutenberg

Seneca, Briefe an Lucilius, Brief 108, in: Philosophische Schriften IV, Hamburg: Meiner, 1993

Wissenschaftstheorie 4: Die Akteur-Netzwerk-Theorie

Wenn Maschinen mitreden: Was die Akteur-Netzwerk-Theorie über die KI verrät

Die Sonderstellung des Menschen wankt. In einer zunehmend digitalisierten Welt ist das Handeln nicht mehr allein dem Menschen vorbehalten. Technologien wie Künstliche Intelligenz (KI) treten als eigenständige Kraft auf – oder präziser: als Teil eines hybriden Akteurs, der Mensch und Maschine kombiniert.

Die Akteur-Netzwerk-Theorie (ANT), entwickelt unter anderem von Bruno Latour, bietet dafür ein spannendes Erklärungsmuster: Soziales entsteht nicht allein durch Menschen, sondern in Netzwerken verschiedenartiger Elemente, menschlicher und nichtmenschlicher. Der Einzelne handelt selten isoliert, sondern meist in einem dichten Geflecht aus Dingen, Konzepten, Menschen und Institutionen.

Was die Akteur-Netzwerk-Theorie erklärt

Zentrale Begriffe der ANT sind Akteur, Netzwerk und Übersetzung. Letztere meint: Informationen und Wirkungen werden durch verschiedene Vermittler ständig transformiert. In Bezug auf KI bedeutet das: Der Mensch, der eine Frage an einen Chatbot stellt und die Antwort nutzt, ist nicht mehr ein autonomes Subjekt, sondern Teil eines dynamischen soziotechnischen Netzwerks.

KI als Mittler – aber kein neutraler

Die KI ist dabei nicht einfach ein Werkzeug, das Daten weiterreicht. Sie verändert die Daten. Ähnlich wie eine Axt einen Holzblock zerteilt und aus demselben Material Brennholz macht, zerlegt die KI Daten in kleinste Einheiten (Tokens) und formt daraus neue Antworten. Doch sie entscheidet mit – durch Trainingsdaten, Modelle, Algorithmen. Neutral ist sie nicht.

Trotz ihrer Leistung bleibt die KI eine Black Box. Wie sie genau aus Daten Bedeutungen formt, ist nicht nachvollziehbar. Selbst die Entwickler:innen wissen oft nicht, wie ein Modell zu einem bestimmten Ergebnis kommt. Die Übersetzung von Eingabe zu Ausgabe ist nicht transparent.

Jede Abfrage schafft ein neues Netzwerk

Künstliche Intelligenz verhält sich wie ein Chamäleon: Sie verändert ihr Verhalten mit jedem Prompt, jeder Modifikation, jeder neuen Datengrundlage. Auch das Einbeziehen aktueller Internetdaten führt zu wechselnden Ergebnissen. Jedes Mal, wenn eine KI gefragt wird, entsteht ein neues Netzwerk, das kurz aufblitzt – und wieder vergeht.

Das Versprechen besserer Modelle – und seine Grenzen

Viele setzen Hoffnung auf sogenannte „reasoning systems“: Mächtige KI-Modelle, die Schritt für Schritt argumentieren und dies auch anzeigen. Doch laut einem Übersichtsartikel1 zu aktuellen Tests erzeugen fortgeschrittene Modelle ein Mehrfaches an Fehlern im Vergleich zu früheren Systemen. Die Maschine spricht mit sich selbst. Das Werkzeug bearbeitet das Werkzeug. Die KI verhandelt mit der KI und verwirrt zuerst sich und dann den Menschen. Verlässlich ist sie nicht.

14. Mai 2025

PS: Auch Schimpansen, Krähen oder Delfine nutzen Werkzeuge. Die ANT beschreibt also nicht nur menschliches, sondern soziales Handeln allgemein: das Geschehen zwischen Lebewesen, Dingen und Kontexten. Vielleicht ist das die wahre Stärke dieser Theorie – sie denkt das Soziale weit über den Menschen hinaus.

1 Metz, C., Weise, K. (08. Mai 2025). A.I. hallucinations are getting worse. The New York Times (International Edition), S. 8.

Glocke und am Seil ziehender Mesner als Beispiel für einen (einfachen) hybriden Akteur.

Das Läuten an der Glocke hat Einfluss auf den Lebensrhythmus der Bevölkerung in der Umgebung.

KI und Wissenschaftstheorie 1: Der Pragmatismus

Wenn Maschinen antworten – und wir trotzdem weiterfragen müssen

Im Herbst 2022 schlug ChatGPT in die öffentliche Wahrnehmung ein wie ein Meteorit. Plötzlich konnten Maschinen auf alles eine Antwort geben: blitzschnell, überzeugend, sprachlich versiert. Ein erstaunliches Werkzeug.

Aber auch ein Anlass zu fragen: Wie verändert KI unser Verständnis von Wissen? Das über Jahrhunderte durch Vernunft, logische Vorgehensweisen und Experimente angehäufte Wissen wird durch die KI nun verändert. Wird es aber angereichert oder verwässert?

Zwischen Funktion und Verstehen

Die Reaktionen auf den neuen digitalen 'Partner' reichen von Euphorie bis zur intellektuellen Kapitulation. Viele Nutzer sehen KI pragmatisch: "Hauptsache, es funktioniert." Wenn eine Software plausible Texte schreibt, hilfreiche Tipps liefert und Daten analysiert – warum weiter nachdenken?

Doch diese Haltung greift zu kurz. Sie blendet aus, dass die KI keine Wahrheit kennt, sondern nur Muster. Sie verarbeitet vorhandene Daten und optimiert auf statistische Wahrscheinlichkeit, nicht auf epistemische (erkenntnistheoretische) Tiefe. Genau hier setzt die Wissenschaftstheorie an. Denn sie fragt: Was gilt als Wissen, und warum?

Die pragmatische Antwort

Eine lohnenswerte Perspektive liefert der philosophische Pragmatismus, wie ihn Charles S. Peirce, William James und John Dewey vor eineinhalb Jahrhunderten formuliert haben. Feste Hintergrundannahmen über die „Natur“ von KI oder der Realität gibt es nicht. Pragmatisten sehen Erkenntnisse als Ergebnis eines fortlaufenden Prozesses an.

Gelernt wird über trial and error. Statt nach objektiver Wahrheit im absoluten Sinn zu suchen, setzen Pragmatisten auf praktische Bewährung: Wahr ist, was dem Leben und Handeln nützt. Erkenntnis entsteht im Prozess, im Versuch, im Irrtum, in der Korrektur.

Die heftige Kritik an der Nutzenorientierung ist ebenfalls eineinhalb Jahrhunderte alt: Demnach würde der Pragmatist mit dem Verlust der methodischen und analytischen Sorgfalt einfach alles billigen. Was leider häufig in der Praxis zutrifft. Entscheidend ist jedoch, dass man nicht das erstbeste Ergebnis nimmt.

Das führt uns zu Peirces Bild vom "Seil": Wissen ist nicht ein Faden, der reißt, wenn eine Annahme falsch ist. Wissen ist ein Seil aus vielen Fasern. Auch wenn einzelne Fasern schwach oder brüchig sind, hält das Ganze durch Verflechtung.

Auf die Forschung angewendet: Je mehr Perspektiven, Methoden und Daten wir verknüpfen, desto robuster wird unser Verständnis. Triangulation heißt diese Verknüpfung heute. Diese wiederum obliegt dem Menschen.

KI als Werkzeug im Erkenntnisprozess

KI kann dabei ein starkes Werkzeug sein. Aber sie bleibt die Faser, ein kleiner Teil des Seils, nicht das Seil selbst. Ihre Antworten sind Anregungen, keine Endgültigkeiten, sie sind kleine Schritte im Forschungsprozess.

In dieser Hinsicht ist der Pragmatismus aktueller denn je. Sie erinnert uns daran, dass Erkenntnis dynamisch ist. Dass Wahrheit nicht gefunden, sondern immer wieder – zwischen Menschen – verhandelt wird. Und dass umfassendes Denken nicht delegierbar ist, auch nicht an scheinbar klügste Maschinen.

6. Mai 2025

Pragmatismus in Venedig (2024):

Obstkisten sind nicht nur fürs Transportieren oder Präsentieren nützlich, sondern auch für den Standaufbau.

Prompt-Engineering VII:

Wie ich KI nutze – und was mich dabei nachdenklich stimmt

Hallo Reinhard,

sag mal, wie hältst du’s mit der KI?

Nun, ich nutze Chatbots. Rund 350 Millionen Menschen weltweit tun das gegenwärtig1. Besonders helfen mir die Bots, grammatikalische Fehler auszubessern, Argumente zu schärfen und den roten Faden klarer herauszuarbeiten. Dabei folge ich einer bewährten Methode – dem “Sandwich-Ansatz”:

1. Erst das Rohkonzept. Ich schreibe einen Entwurf, der einige Tage insofern auf meinem Laptop reift, als ich ihn Immer wieder modifiziere: durch neue Gedanken, andere Beispiele, schärfere Formulierungen. Am Ende enthält der Text meine wichtigsten Ideen und Argumente.

2. Dann die KI. Erst jetzt lasse ich einen Chatbot über den Entwurf ‚schauen‘. Mit präzisen Prompts (siehe frühere Beiträge im Blog) bitte ich um gezielte Verbesserungsvorschläge.

3. Schließlich die Feinarbeit. Ich prüfe die Vorschläge. Viele übernehme ich ganz oder in Teilen, einige verwerfe ich.

Dabei fällt mir auf: Die KI möchte oft gleich einen komplett überarbeiteten Text liefern. Sage ich “ja”, entstehen wunderbar fließende Formulierungen – angenehm wie eine warme Dusche. Der Text liest sich leicht. Vielleicht zu leicht.

Denn: Das Originelle verschwindet. Ungewöhnliche Gedanken oder schräge Beispiele werden von der KI regelmäßig gestrichen. Kein Wunder: Sie wurde mit der Vergangenheit trainiert – auf das durchschnittliche Bisherige und nicht auf das Neue.

Und genau hier liegt die Gefahr: Die Chatbots reproduzieren, was schon da war. Innovation bewerten sie als Störung. Wenn wir uns darauf verlassen, spinnen wir – wie eine Seidenraupe – einen Kokon aus kristallklaren, aber glatten Gedanken. Und schotten uns so langsam gegen echte Neuerungen ab.

Also baue ich urspüngliche Gedanken und Beispiele wieder ein.

28. April 2025

1 Statista (17.04.2025). „KI-Nutzung explodiert: 950 Millionen Menschen bis 2030.“

Prompt-Engineering VI:

Warum die Anweisung entscheidend ist

KI-Tools wie ChatGPT, Perplexity, Claude, DeepSeek sind dann besonders hilfreich, wenn wir ihnen klare Aufgaben geben. Im Hochschulkontext bedeutet das: Wer mit KI arbeiten will, sollte wissen, wie ein effizienter Prompt aufgebaut ist. Eine vereinfacht Grundstruktur eines Prompts hat drei Hauptelemente:

1. Rolle → 2. Kontext → 3. Anweisung

In diesem Blogbeitrag geht es um den dritten Teil: die Anweisung.

Was ist die Anweisung

Die Anweisung ist jener Teil des Prompts, der der KI sagt: Tu das!

Eine präzise formulierte Anweisung sorgt dafür, dass die KI genau versteht, was erwartet wird. Sie ist das Herzstück des Prompts. Ohne sie bleibt der Output vage oder ist unbrauchbar. In den meisten Fällen merkt der Anwender das nicht sofort, denn die KI formuliert blendend.

Die KI gaukelt dir Glänzendes vor, obwohl nur Durchschnittliches oder gar ungeeignete Information angeboten wird.

Beispiel:

"[Rolle:] Du bist ein wissenschaftlicher Lektor. [Kontext:] Ich schreibe eine Hausarbeit über soziale Ungleichheit. [Anweisung:] Überarbeite den folgenden Text auf wissenschaftlichen Stil, logische Struktur und sprachliche Präzision. Gib mir auch Hinweise, was und warum du etwas verbessert hast."

Durch die zwei Wörter („und warum“) wird ein rückbezüglicher Lernvorgang eingeleitet. Die KI nennt Gründe für die Verbesserung des ursprünglich erstellten Textes.

Die eigenen, zumeist charakteristisch ähnlich ablaufenden Denkprozesse können so mit der Zeit logisch konsistenter werden. Die KI wird zum persönlichen Trainer und Coach. Eine Verbesserung der Denkvorgänge ist ja ein, wenn nicht das Hauptziel tertiärer Bildung.

Drei zentrale Merkmale einer gelungenen Anweisung

- Klarheit

Was genau soll getan werden? Die Aufgabe muss eindeutig sein, die Formulierung daher präzise. - Zielorientierung

Warum soll die KI das tun? Was ist das gewünschte Ergebnis? - Formatangabe

Wie soll die Antwort aussehen? Aufzählungspunkte, Tabelle, Fließtext?

Weitere Beispiele

"[Rolle:] Du bist ein Tutor für Soziologie. [Kontext:] Ich bereite mich auf eine Prüfung vor. [Anweisung:] Erkläre mir die Theorie von Pierre Bourdieu zur sozialen Kapitalbildung in einfachen Worten. Gib ein konkretes Beispiel und verweise auf Primärliteratur."

An Hochschulen und Universitäten sind Angaben zu Quellen Pflicht. Diese Quellenangaben sind zu prüfen, weil der KI auf diesem Gebiet nicht zu trauen ist.

"[Rolle:] Du bist KI-Textkritiker. [Kontext:] Ich habe einen Rohtext für ein Abstract geschrieben. [Anweisung:] Gib mir Verbesserungsvorschläge in Stichpunkten, ohne den Text umzuformulieren."

Je nach Aufgabenstellung und Stand des Entstehungsprozesses der Antwort können weitere Merkmale einer gelungenen Anweisung genannt werden. Zum Beispiel die Nennung von Grenzen des KI-Tuns, wie bestimmte Stellen unverändert zu lassen.

Fazit: Eine gut formulierte Anweisung spart Zeit, verbessert die Ergebnisse und hilft, mit der KI zu lernen.

22. April 2025

Prompt-Engineering V:

Für wen schreibe ich eigentlich?

Diese Frage ist nicht nur für Menschen entscheidend, die Texte verfassen – auch Künstliche Intelligenz braucht sie, um zielgerichtete Antworten zu geben. Beim Prompt-Engineering an der Hochschule gilt: Wer sein Publikum kennt, bekommt die besseren Ergebnisse.

Warum Zielgruppen beim Prompt-Engineering wichtig sind

KI antwortet nicht einfach neutral. Sie orientiert sich an dem, was ihr mitgeteilt wird: Thema, Ziel, Stil – und eben auch das Publikum. Wer bei der Prompt-Formulierung klarmacht, für wen die Antwort gedacht ist, erhöht die Relevanz und Qualität der Antwort deutlich.

Es lohnt sich, zwei Ebenen zu unterscheiden:

- Publikum 1 (P1) = der Prompter, also der Mensch, der die Anfrage formuliert.

- Publikum 2 (P2) = die Zielgruppe, für die P1 die Antwort benötigt.

Je nach Beziehung zwischen P1 und P2 verändern sich der Sprachstil, die Breite oder Tiefe der Antwort, das verwendete Vokabular. Eine gute KI-Antwort ist dann wie ein Maßanzug: Sie passt perfekt zum Publikum.

Die zwei Publika: Anwender und Adressat

P1 ist nahezu immer der Ausgangspunkt und sollte im Prompt erkennbar sein: Wer fragt und mit welchem Ziel?

P2 gibt der KI eine weitere Dimension vor. Wer ist die spezielle Zielgruppe? Was weiß diese schon, was braucht sie noch? Das macht die Antwort nicht nur präziser, sondern auch anschlussfähiger an die Zielgruppe und daher nützlicher.

Typische Zielgruppen im Hochschulkontext

Im akademischen Umfeld lassen sich typische Zielgruppen definieren. Wer Prompts für KI schreibt, sollte sich klar machen, in welche Kategorie das Publikum fällt:

- Studierende: Benötigen meist eine erklärende Darstellung mit konkreten Beispielen und klaren Definitionen. Hilfreich sind außerdem Hinweise auf Primärquellen zur Vertiefung.

- Lehrende an Unis und Hochschulen: Erwarten eine detaillierte, wissenschaftlich argumentierende Antwort, die aktuelle Forschungsliteratur einbezieht, methodisch begründet ist und kritische Reflexion zulässt.

- Fachpublikum: Etwa auf Konferenzen oder als Leserinnen wissenschaftlicher Journale. Es erwartet eine tiefgehende Analyse mit fachterminologischer Präzision, kritischer Diskussion und Anbindung an den aktuellen Forschungsstand.

- Interdisziplinäres Publikum: Sollte übergreifend verständlich angesprochen werden. Basis: Maturaniveau. Gleichzeitig sollte es Zugang zu weiterführender Fachliteratur erhalten.

- Wissenschaftsrelevante Spezialpublika: Hierzu zählen Politikerinnen, Journalistinnen, Verlagsmitarbeitende oder Influencerinnen in sozialen Medien. Sie benötigen wissenschaftlich fundierte, aber zugleich praxisnahe und umsetzungsorientierte Inhalte.

- Breites interessiertes Publikum: Segmente der allgemeinen Bevölkerung. Es sollte allgemein verständlich angesprochen werden. Hier ist ein wissenschafts-journalistischer Stil angemessen.

Prompt-Beispiele aus Wirtschafts- und Pflegewissenschaften

"Ich bin ein Masterstudent der Wirtschaftswissenschaften und soll ein Handout für ein Leadership-Seminar erstellen. Erkläre den Unterschied zwischen transaktionaler und transformationaler Führung so, dass meine Kommilitonen in der Lehrveranstaltung diesen gut nachvollziehen können."

"Ich bin eine Pflegefachkraft in der Weiterbildung zur Praxisanleitung möchte für einen Schulungstag eine KI-generierte Einführung in das Konzept der aktivierenden Pflege erstellen. Der Text soll für Auszubildende im ersten Lehrjahr leicht verständlich und praxisnah formuliert sein."

Diese beiden Beispiele zeigen, wie konkret ein Prompt sein kann – und wie hilfreich diese Konkretisierung für die KI ist.

Fazit: Für kluge Prompts zählt das Publikum

Prompt-Engineering ist mehr als Technik: Es ist Gestaltung der Kommunikation. Wer seine Zielgruppe kennt, hilft der KI, bessere Texte zu erstellen – sei es für Vorträge, Hausarbeiten oder Forschungskommunikation.

16. April 2025

Prompt-Engineering IV:

Was macht einen Prompt gut? Der Kontext.

Stell dir vor, du gibst einer KI den Auftrag: „Schreib mir eine Zusammenfassung über soziale Ungleichheit.“ Klingt einfach. Doch ohne Kontext weiß die KI nicht, für wen, in welchem Stil oder mit welchem Ziel sie schreiben soll. Genau hier kommt der Kontext ins Spiel – und der ist viel mehr als nur 'Um'-Feld.

Kontext ist Gewebe, nicht Kulisse

Das Wort „Kontext“ kommt vom lateinischen contextus – es bedeutet „das Zusammengewebte“. Das Wort Contextus enstand aus einer Verbindung von con (mit) und texere (weben)1. Etwas Zusammengewebtes, also ein Textil, ist mithin ein flächiges Gebilde, das aus mindestens zwei Fadensystemen (Kette und Schuss) besteht. Es können auch mehrere Fadensysteme eingewoben sein, wobei gilt: Je dichter gewebt, umso stabiler ist das Gewebe.

Der Kontext ist mithin das gesamte Bedeutungsfeld, das Einfluss auf die Interpretation von Zeichen, Texten oder Kommunikationsakten hat. Er umfasst sprachliche und nichtsprachliche (situative, psychologische, soziale und kulturelle) Faktoren, die das Verstehen und Verhalten steuern.

Umgesetzt auf Sprache und Kommunikation heißt das: Ein einzelner Aspekt – Inhalt, Situation, Tonfall oder Zielgruppe – reicht nicht. Erst im Zusammenspiel ergibt sich Bedeutung. Deshalb ist „Kontext“ nicht bloß eine nette Nebensache. Und schon gar kein Umfeld, das man zur Not ignorieren kann. Wer nur einen einzelnen Faden betrachtet, verkennt das ganze Muster.

Kathedrale von Sevilla, Andalusien/Spanien

Warum Kontext im Prompt-Engineering entscheidend ist

Im Umgang mit KI ist Kontext ein zentrales Gestaltungselement. Wir können Teile des Kontexts direkt in die Anweisung schreiben („Stell dir vor, du bist eine Lektorin…“) oder sie der KI zuschreiben („Du bist ein wissenschaftlicher Assistent für Soziologie“). So steuern wir, wie die KI antwortet – fachlich, stilistisch, sprachlich.

Ein effizienter Prompt berücksichtigt den fachlichen Rahmen. Der Kontext sollte in der akademischen Umgebung den jeweils spezifischen Bereich darlegen:

- Fachbereich: Naturwissenschaften, Geisteswissenschaften, Ingenieurwesen etc.

- Studienniveau: Bachelor, Master, Doktorat

- Anwendungsfall: Literaturrecherche, Hausarbeiten, wissenschaftliches Schreiben, Prüfungsvorbereitung etc.

Zum Beispiel: „Die Nutzer sind Masterstudierende der Sozialwissenschaften. Sie schreiben eine Hausarbeit zu einem theoretischen Thema. Die KI soll beim Strukturieren, beim präzisen Argumentieren und bei der Suche nach geeigneten Quellen helfen.“ So ein Kontext schafft Orientierung – für die Maschine und für den Menschen.

Welt als Gewebe – nicht als wissenschaftliche Insel

Zum Schluss ein Gedanke über den Tellerrand hinaus: Viele Disziplinen arbeiten in engen Bereichen und nennen alles andere „Umfeld“. Doch diese oft historisch bedingten und künstlic geschaffenen Grenzen versperren die Sicht auf die große Welt. Kontext-Denken bedeutet, Disziplinen verknüpfen, statt sie zu isolieren.

8. April 2025

1 Chambers Dictionary of Etymology (2008). Context. H. W. Wilson, S. 213

Prompt-Engineering III:

Stil und KI-Rolle

Der Einfluss des Prompt-Engineerings auf den Stil wissenschaftlicher Texte

Der Einsatz von Künstlicher Intelligenz (KI) in wissenschaftlichen Arbeiten erfordert nicht nur die Beachtung inhaltlicher Kriterien, sondern auch stilistische Überlegungen. Wissenschaftliche Texte folgen strengen Regeln hinsichtlich Sachlichkeit, Nachvollziehbarkeit und struktureller Klarheit. Die Art, wie ein Prompt formuliert wird, beeinflusst maßgeblich die Antworten der KI.

Der Stil in wissenschaftlichen Arbeiten

Wissenschaftliche Texte sind geprägt von einer präzisen, objektiven und neutralen Sprache – oder streben das zumindest an. Emotionale oder subjektive Formulierungen sind zu vermeiden, jede Aussage sollte nachvollziehbar, begründet und belegt sein. Eine KI, die für akademische Zwecke eingesetzt wird, ist daher so zu instruieren, dass ihre Antworten diesem Stil entsprechen.

Eine weniger formelle Anrede oder eine umgangssprachliche Formulierung wird dazu führen, dass die KI in einem lockeren und weniger präzisen Stil antwortet. Das allerdings ist in wissenschaftlichen Texten nicht erwünscht.

Unterschiedliche Rollen der KI und ihre stilistischen Ausprägungen

Festzuhalten ist jedoch: Nicht alle KI-Rollen in der Wissenschaft erfordern den objektivierenden Stil. Während analytische Texte einen sachlichen Stil voraussetzen, kann die KI in anderen Kontexten, etwa als Motivationscoach bei Schreibblockaden, einen persönlichen Tonfall annehmen. Hier wird es sinnvoll sein, die KI bereits mit einer freundlichen Sprache zu adressieren, um unterstützende Wirkung zu erzielen: Sprich die KI mit "du" an, sag eventuell "bitte". Die KI antwortet dann vielleicht mit „Gerne. ...“.

Nicht dass der Chatbot nun Gefühle entwickelt hätte, aber ein solcher Stil hat den Vorteil, dass DU (die Anwenderin, der Anwender) durch die persönliche Antwort dich unmittelbar angesprochen fühlst. Ein Beispiel:

- Wissenschaftlicher Textbaustein: „Erkläre die Prinzipien des Prompt-Engineerings in wissenschaftlichen Arbeiten mit Fokus auf Objektivität und Nachvollziehbarkeit.“

- Motivationsfördernder Textbaustein: „Ich brauche Unterstützung, um meine Masterarbeit weiterzuschreiben. Ermutige mich bitte mit positiven Formulierungen und konkreten Schreibtipps.“

Was der Chatbot nicht erleben kann: den Sonnenaufgang in einer chilenischen Wüste

Risiken und ethische Aspekte der KI-Nutzung

Die Nutzung von KI in akademischen Arbeiten birgt neben stilistischen Fragen auch ethische Herausforderungen für alle Beteiligten. Insbesondere bei der Interaktion mit KI-gestützten Tools geben Nutzende persönliche Informationen preis. Und diese werden von den marktdominierenden US-amerikanischen Tech-Konzernen wohl sofort ausgewertet. Um Datenschutzrisiken zu minimieren, empfiehlt es sich, Chatbots gelegentlich zu wechseln.

Hier bietet sich etwa die chinesische DeepSeek-App an. Jedoch das aber bedeuten, dass man vom "Regen in die Traufe" kommt. Zumindest wären dann die Risiken geteilt und damit insgesamt kleiner. Europäische Anbieter mit höheren Datenschutzstandards sollten bevorzugt werden. Sie sind derzeit noch klein, aber fein.

Beispiele hierfür sind Aleph Alpha aus Deutschland für Unternehmen oder Le Chat von Mistral AI aus Frankreich (leider kostenpflichtig). Sie halten sich an die DSGVO-Richtlinien der EU.

Fazit

Das Prompt-Engineering spielt eine zentrale Rolle für die Qualität und den Stil von KI-generierten wissenschaftlichen Texten. Eine bewusste Steuerung des Tonfalls hilft, präzise und den akademischen Standards entsprechende Antworten zu erhalten. Gleichzeitig sollte der Schutz der eigenen Daten nicht aus den Augen verloren werden.

31. März 2025

Die Rolle

(Prompt-Engineering II)

Zur Wiederholung: Prompt-Engineering bedeutet die gezielte Gestaltung von Eingaben, um von einer KI präzise und relevante Antworten zu erhalten. Wir haben das letzte Mal drei Dimensionen eines effektiven Prompts angesprochen: Rolle, Kontext und Anweisung. Einige ausgewählte KI-Rollen werden nun aus Sicht von Studierenden an Universitäten und Hochschulen näher betrachtet.

Das Problem klar formulieren

Zuerst kläre das aktuelle Problem – genauso, wie es bei wissenschaftlichen Arbeiten im Rahmen der Einleitung erfolgt. Dieses Problem reicht von der Themensuche bis zur grammatikalischen und stilistischen Endkorrektur. Auf das Problem (oder das Erkenntnisinteresse) wird die spezifische Rolle der KI angepasst. Hier drei Beispiele:

- „Ich weiß nicht, wie und wo ich anfangen soll.“ Dann kann die KI in der Rolle als Berater, Motivationscoach oder Strukturoptimierer Vorschläge machen. Ich schreibe deshalb Strukturoptimierer und nicht Strukturentwickler, weil die grundsätzliche Gliederung als Basiswissen bzw. als Erstvorschlag vom Studenten selbst kommen sollte.

- „Mein Text ist nicht im wissenschaftlichen Stil formuliert.“ Hier könnte die KI als Lektor oder als Kritiker eingesetzt werden.

- „Wie soll ich die vorhandenen (oder demnächst zu erhebenden) Daten analysieren?“ Nutze die KI als Argumentations- bzw. Begründungsberater, als Methodencoach oder als Datenanalyst.

Wie aus meinen Kommentaren zu den drei Beispielen erkennbar wird, können zahlreiche Rollen relevant werden. Im Folgenden werden zwei Rollen detaillierter behandelt.

Eine Rolle zuweisen

Teile die jeweilige Rolle der KI explizit mit: „Du bist in der Rolle eines XXXX [zB eines Methodencoaches].“

Was die KI an Funktionen in einer spezifischen Rolle leistet:

- In der Rolle als Berater: Hier könnte die KI das Thema eingrenzen. Ein häufiger Fehler ist eine zu breite Themenwahl bei der Gliederung. Dies geschieht oft aus der Sorge der Studierenden, nicht genug Stoff für das Schreiben zu finden. Eine meist unbegründete Sorge.

Weitere ergiebige Fragen in der KI-Rolle als Berater sind: "Wie können die gewählten theoretischen Konzepte/Modelle mit der Empirie verbunden werden?" oder "Wie können die Ergebnisse mit aktuellen gesellschaftlichen Entwicklungen verknüpft werden? "

- In der Rolle als Recherche-Assistent: In dieser Rolle sollte die KI mit Bedacht eingesetzt werden! Die Antworten sind für eine seriöse akademische Recherche meist zu fehleranfällig und unzuverlässig. Aktuelle Suche in der Fachliteratur zur spezifischen (von der KI kaum richtig zu erkennenden) Forschungslücke bleiben Aufgabe des Studierenden.

Sonst gibt es Allerweltsantworten, die Durchschnittliches aus der Vergangenheit spiegeln. Dies genügt nicht wissenschaftlichen Standards! Für Dissertationen etwa erwartet man grundsätzlich Neues. Die Rolle als Recherche-Assistent ist jedoch hilfreich, wenn man rasch eine Zusammenfassung einer ausführlichen Studie benötigt.

Nachdem die Rolle der KI definiert wurde, bleibt eine zentrale Frage: Wie sind die Antworten der KI zu bewerten? Damit die Zuweisung einer Rolle zu verwertbaren und akademisch seriösen Ergebnissen führt, ist eine richtige Verarbeitung der Antworten entscheidend. Genau hier greift die Sandwich-Regel.

Die Sandwich-Regel als Leitprinzip

Eigenständiges Denken steht vor dem Einsatz von Chatbots. Erst danach kommt die KI zur Anwendung. Die Beurteilung, Überprüfung und Weiterverarbeitung der KI-Antworten obliegen wieder dem Nutzer. Die KI ist lediglich die 'Füllmasse' im Sandwich.

Richtig vorgegangen zeigt sich ein lernpsychologischer Effekt: Klar zu denken ist das Allerwichtigste. Die Fähigkeit, zwischen hilfreichem und unbrauchbarem Output zu unterscheiden, bleibt eine zentrale menschliche Kernkompetenz. Doch der Umgang mit fehlerhaften oder ungeeigneten Antworten lässt sich erlernen.

Strukturierendes und logisches Denken sowie entsprechendes Formulieren lassen sich letztendlich nicht an die KI übertragen. KI kann den Boden für ein fruchtbares Lernen bereiten. Chatbots sollen zum Beispiel genutzt werden, ineffiziente Recherchen zu verringern. Das wiederum erhöht die Freude am eigentlichen Forschen und am Schreiben einer wissenschaftlichen Arbeit.

20. März 2025

Prompt-Engineering I

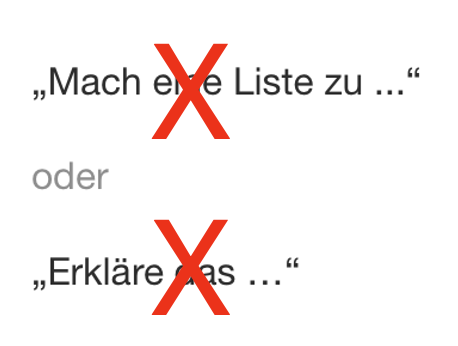

Studenten nutzen seit fast zweieinhalb Jahren die generative KI für ihr Studium. Allerdings regelmäßig mangelhaft. Sie starten den Chatbot und schreiben ohne viel nachzudenken einfache Anweisungen wie „Mach eine Liste zu ...“ oder „Erkläre das …“

Doch diese unspezifischen Anfragen liefern nur mittelmäßige Antworten. Sie gleichen Einheitsgrößen in der Kleiderbranche: passend für viele, aber selten perfekt. Die Antworten der Chatbots sind durchschnittlich und wenig auf das jeweilige Problem zugeschnitten. Leider merken die Anwender nicht, dass sie nur einen Bruchteil des tatsächlichen KI-Potenzials ausschöpfen.

Unspezifische Prompts wirken wie ein Jäger, der blind in die Luft schießt – und dennoch erwartet, dass ihm gerupfte und gebratene Enten vor die Füße fallen. Also:

So funktioniert das nicht. Doch wie dann?

Large Language Models (LLMs) zeigen große Problemlösungsfähigkeiten. Die KI-Effektivität jedoch variiert enorm. Die Effektivität ist abhängig von der Formulierung der Anweisung (Prompts). Sie ist überdies kontingent. Das heißt, die Antworten sind mal so, mal so, abhängig von modellinternen Strukturen und Prozessen. Umständen, die wir nicht erkennen oder nur wenig beeinflussen können.

Die Kunst des Prompt-Engineering – also das gezielte Formulieren von Anweisungen an die KI – hat sich zu einer gefragten Fähigkeit entwickelt. Soziale Medien sind voller Beispiele, und Influencer versuchen mit spezifischen Prompt-Techniken, Follower (und damit Geld) zu gewinnen.

Warum die Formulierung von Prompts entscheidend ist

Doch um das volle Potenzial von KI-Modellen auszuschöpfen, reicht es nicht, diese Techniken zu kopieren. Man muss verstehen, wie die Modelle grundsätzlich funktionieren. Wer KI sinnvoll anwenden will, benötigt daher ein solides Grundwissen

Eine der Grundstrukturen eines effektiven Prompts

Die effektive Nutzung von Chatbots beruht auf einer klaren Struktur:

- Rolle: Wer gibt die Antwort? Die KI erhält eine klare Rolle und weiß, aus welcher Perspektive die Anfrage zu beantworten ist.

- Kontext: In welchem Zusammenhang steht die Anfrage? Der Kontext hilft der KI, die Situation besser einzuordnen.

- Anweisung: Was soll konkret geschehen? Die Anweisung sollte präzise und eindeutig sein.

Ein Beispiel

„Du bist ein Experte für Musikpädagogik. Ich bin mäßig fortgeschritten im Klavierspiel. Wie soll ich vorgehen, damit ich klassische Musikstücke besser auswendig lerne?“

Mehr über das Prompt-Engineering im Folgeblog.

12. März 2025

Die KI kennt sich nicht aus.

(In realiter: Eine Gruppe nachts in Nordnorwegen am Feuer, die auf das Erscheinen von Polarlichtern wartet.)

Wie Hochschulen mit KI überfordert sind –

und warum ihre Regeln scheitern

„Schluss mit absurden KI-Regeln!“1 – dieses Statement von Doris Wessels, Professorin für Wirtschaftsinformatik, schlägt Wellen in netzbasierten Medien2. Wessels berichtet von einem AbsurdKIstan an Hochschulen. Seltsame Regeln für den Einsatz von Chatbots lassen vermuten, dass nicht wenige Hochschulen überfordert sind, selbst mehr als zwei Jahre nach ChatGPT-Einführung.

KI-Nutzung erschüttert das Bildungssystem. Massenhaft und unreflektiert werden Inhalte übernommen, hierzu wurde ein eigener Begriff erfunden: der AI-Giarismus, vermutlich entstanden als Ableitung und Pendant zum Plagiarismus. Betroffen sind beide involvierten Akteure: Studierende und Hochschulen.

Die Unehrlichkeit (Faulheit?) der Studenten trifft auf die mangelnde Bereitschaft der Hochschulen, fundiert und effektiv damit umzugehen. Kein Wunder, dass dies entsprechende Diskussionen in internationalen Konferenzen befeuert3. Wie einfach war der gute alte Plagiarismus.

Hilflosigkeit

Hochschulen schwanken zwischen KI-Verboten und veralteten Regeln, etwa dem Zitieren des Urhebers einer Aussage. Und deshalb sollen nun KI-Programmierer zitiert werden, so eine Hochschule laut Wessels.

Sind KI-Programmierer die Urheber? Soll der Programmierer als Quelle zitiert werden? Nein, sie schreiben die Texte ja nicht. Sie stoßen vielmehr die KI an, verbale Splitter aufgrund statistischer Beziehungen zwischen abstrakten Kategorien zu jonglieren.

Inadäquate Regeln zeugen von Hilflosigkeit. In der realen Welt stößen Zitierende sofort auf die Barriere, dass die Programmierer unbekannt sind. Ist dann ersatzweise Sam Altmann zu nennen, weil er der CEO von OpenAI ist? Unbrauchbare KI-Regeln zeigen, dass klassische Zitierregeln versagen. Gefragt ist eine intelligente Anpassung. Wäre dies nicht gerade von „Hoch“-Schulen und Universitäten zu erwarten? Wo, wenn nicht hier?

Angriff auf das Zitieren, ein Fundament der Wissenschaft

Seit mehreren Jahrhunderten verlangt die Wissenschaft exakte Quellenangaben. KI-Regeln, die auf diesen Vorgaben fußen, offenbaren ein zentrales Warum des Zitierens: Die Wurzel eines Gedankens oder Konzeptes soll lokalisiert werden.

Die kontextuell mitschwingende Gedanken- und Erfahrungswelt des Autors kann erkundet und nachverfolgt werden. Wir erkennen unzureichende Schlussfolgerungen oder implizit getroffene Annahmen. Aussagen können so von der wissenschaftlichen Community relativiert werden. Dadurch steigt der Wahrheitsgehalt eines Gedankens oder Konzepts.

Wir bauen durch Zitieren gesicherte Gedanken- und Ideennetze auf, ohne jedesmal neu bei Adam und Eva anzufangen. Genau das passiert, wenn man die KI unkontrolliert einsetzt. Ein Zurückfallen in eine Zeit, wo alles Geschriebene per se heilig war. Was damals wie heute Konsequenzen hat:

Gefangen im Nebel überzeugend klingender Sätze wissen wir nun nicht, was wahr ist oder nur gut erdichtet.

23. Februar 2025

Blockierendes Geröll in unübersichtlicher Lavahöhle auf Lanzarote

1 Wessels, D. (16.01.2025). Die Zeit. Die Position: Schluss mit absurden KI-Regeln! https://www.zeit.de/2025/03/kuenstliche-intelligenz-studium-hochschulen-regeln.

2 Europa One AI News (16.01.2025). Artificial Intelligence in Higher Education: Ending Absurd AI Rules in German Universities. Criticism of AI Policies in Higher Education. https://oneainews.com/kunstliche-intelligenz-im-studium-ending-absurd-ai-rules-in-german-universities/

3 Mironova, L./Riashchenko, V. et al. (2024). Ethical Concerns in Using of Generative Tools in Higher Education: Cross - Country Study. Environment. Technology. Resources. Rezekne, Latvia. Proceedings of the 15th International Scientific and Practical Conference. Volume II, 444-447, https://vb.kvk.lt/object/elaba:200959443/

Unis ertrinken im KI-Teich

Sie gehen still unter – die Ertrinkenden. Anfangs schlagen sie noch mit den Armen, doch von außen bemerkt es niemand. Wasser füllt die Lunge, sie versinken.

Weissensee in Kärnten

Genauso drohen Hochschulen im Strudel der KI unterzugehen. Sie ignorieren die Entwicklung oder erlassen absurde KI-Regeln1. Verantwortung wird auf Institute oder Dozierende abgeschoben, manche verzichten sogar auf Bachelorarbeiten. Alles unwürdig einer Hochschule.

Dabei erschüttert KI unser gesamtes Privat- und Berufsleben. Doch statt sich aktiv mit den Herausforderungen auseinanderzusetzen, stecken Universitäten den Kopf in den Sand oder treffen Fehlentscheidungen. Wie Verkehrspolizisten, die Autos in die falsche Richtung leiten2.

Sichtbar wurde dieses Dilemma in der Vorbereitung auf das eigentliche Uni-Studium: In Österreich wurde die Verpflichtung zur vorwissenschaftlichen Arbeit (VWA) als Maturabestandteil abgeschafft. Die VWA ist nun eine Option. Das Problem vor die Tür setzen – als wäre es damit gelöst: So einfach macht es sich die nationale Bildungspolitik.

Auch innerhalb der Hochschulen zeigt sich Unsicherheit. Viele setzen neben Plagiatssoftware zusätzlich KI-Erkennungsprogramme ein. Doch diese liefern keine sicheren Ergebnisse, sondern nur Wahrscheinlichkeiten – basierend auf veralteten Trainingsdaten und überholten Modellen. Solche Wahrscheinlichkeiten sind keine verlässliche Grundlage für Urteile. Das wusste man schon in der Antike.

Eine der oft negierten Wurzeln des Begriffes Wahrscheinlichkeit liegt in der Dichtkunst. Beispielhaft zu finden beim griechischen Komödiendichter und Satiriker Aristophanes. KI-Entdeckungssoftware malt – gleich einer Schmierenkomödie – jeden Absatz rot, wenn auch nur die geringste Wahrscheinlichkeit eines KI-Einsatzes auftaucht.

Ein konkretes Beispiel zeigt, wie problematisch diese Software ist: Ein Klient berichtete mir 2024, dass zwei, drei Absätze in seiner Masterarbeit wegen angeblicher KI-Nutzung rot markiert wurden. Dabei war er extrem gewissenhaft gewesen, hatte jede Quelle und jedes Zitat akribisch überprüft. Trotzdem erhielten alle (!) Kandidaten eine schriftliche Verwarnung – unabhängig davon, ob nur zwei Absätze oder viele Seiten durchgehend rot aufgeleuchtet hatten.

Unbelegte Behauptungen einer fehleranfälligen Software dürfen kein Urteil begründen! Hochschulen setzen damit ihren Ruf aufs Spiel. Sie zerstören das Vertrauen der Studierenden. Achtung vor der Institution Hochschule? Ertrunken in den Untiefen universitär-systemischer KI-Inkompetenz.

30. Jänner 2025

PS: Müssen wir uns bald an chinesischen Universitäten einschreiben, um den professionellen Umgang mit KI zu erlernen?

1 Darüber mehr in den Folgeblogs

2 Es gibt hell leuchtende Ausnahmen von KI-kompetenten Dozenten und lohnenden Veranstaltungen. Auch darüber später mehr.